hadoop单节点进程退出的问题

当Sqoop上提交了任务到hadoop集群上时,刚开始也挻稳定的,但是跑到3分之二左右的时候就会出现在1个节点

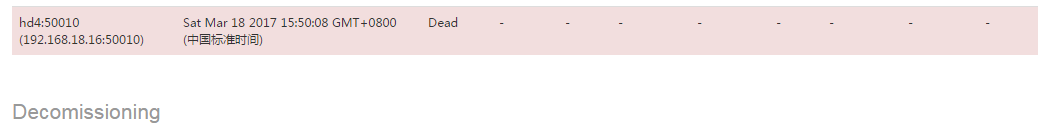

Lost Nodes ,然后登陆服务器查看:jps命令时就发现NodeManager进程确实退出了,由于yarn服务发现速度比较快所以很快就把此节点上的NodeManager服务启动了;过了几分钟后又提示:刚才那个节点的datanode服务也异常退出;

其实在NodeManager服务挂的那时应该datanode服务也挂了;只是默认情况发现状态需要5分钟;

为了不影响服务,马上把服务启动起来。下次再参考官方的动态移除datanode节点的方法修改;

我是直接在Lost Nodes的节点机上上操作:

[hadoop@hd4 sbin]$ ./yarn-daemons.sh --hosts host.txt start nodemanager

[hadoop@hd4 sbin]$ ./hadoop-daemon.sh --hosts host.txt stop datanode

默认这样执行是需要提示密码的,而且是全部集群机器一齐执行,所以我在:hadoop/etc/hadoop/目录下创建一个文件:host.txt 只保存了本机的IP地址;这样执行上面的命令时就会只启动本机的服务;